Expériences sur le potentiel de l'imagerie par IA pour les utilisateurs aveugles

L'intelligence artificielle pourrait aider les personnes aveugles à employer la rhétorique visuelle de manière inattendue

[ Read and share this story in English here ]

Les systèmes d'intelligence artificielle, entraînés à naviguer entre des milliards de textes et d'images de référence, sont capables de synthétiser les messages textuels des utilisateurs en de nouvelles images, extrêmement rapidement et à moindre coût. Avec une simple phrase comme « Photographie de mains touchant une sculpture en bronze », les outils de synthèse d'images par l'IA peuvent générer quasi instantanément des visuels réalistes, attrayants et originaux. Lorsque presque tout le monde pourra créer des images personnalisées et accrocheuses à la demande, la question de savoir quelles images méritent l'attention et ce qu'elles véhiculent deviendra plus importante.

Dans le cadre de ma conception et de ma fabrication d'expositions accessibles à tous, de répliques d'œuvres d'art et d'outils d'orientation destinés à l'exploration pratique, je suis fréquemment amené à préparer et à transmettre des informations non visuelles à des publics aveugles. Naturellement, je me suis demandé si la synthèse d'images par l'IA pouvait être utilisée dans l'autre sens : les personnes aveugles peuvent-elles utiliser les outils de synthèse d'images par l'IA pour communiquer un sens visuel à des publics voyants ?

Incapables d’évaluer ou de garantir directement les propriétés visuelles ou la fidélité des images qu’ils peuvent créer, les utilisateurs aveugles peuvent-ils s’appuyer sur des images générées par l’IA pour communiquer quoi que ce soit de significatif ou de précieux, et d’où viendrait ce sens ?

À l'automne 2022, j'ai demandé à mes collègues Brandon Biggs, Joshua Miele et Lindsay Yazzolino, tous aveugles, s'ils souhaitaient expérimenter ces questions. Les trois chercheurs, tous experts en conception de technologies accessibles, ont rédigé des descriptions sur des sujets variés, allant de l'orientation aux objets du quotidien, en passant par l'infographie et le design, la culture pop et des écrits plus personnels et créatifs. J'ai traité leurs textes dans le système de génération de texte en image Midjourney AI pour produire des milliers de nouvelles images, avec des résultats mitigés et fascinants.

Les images représentant des animaux et des œuvres d'art visuel emblématiques illustrent les défis inhérents et historiques de notre collaboration, ainsi que les capacités et les limites de l'outil. Elles laissent également entrevoir la perspective fascinante de voir des utilisateurs aveugles créer des images et captiver l'attention d'un public voyant grâce à un discours visuel percutant, d'une manière jusqu'alors inédite.

ILLUSTRATION D'UNE ANCIENNE PARABOLE

Brandon Biggs est chercheur, ingénieur et doctorant en informatique centrée sur l'humain au Georgia Institute of Technology. Il est aveugle. Les images ci-dessous ont été générées à partir de sa description d'un animal qu'il a volontairement omis d'identifier : « un grand animal quadrupède doté d'une longue trompe, de grandes oreilles, de longues défenses, d'une peau glabre et d'un corps lourd. »

Par conception, les participants au projet ont décrit nombre de leurs sujets sans les nommer directement. En effet, demander à Midjourney de générer l'image d'un « éléphant », par exemple, lui permettrait d'accéder directement à des images familières, au lieu de tester sa capacité à construire des images à partir des textes uniques des utilisateurs. En laissant nos sujets anonymes, nous avons intégré Midjourney à l'ancienne parabole bouddhiste sur les perceptions contradictoires des aveugles à l'égard d'un éléphant. Nous avons testé la capacité de l'IA à construire des représentations visuelles cohérentes à partir de perspectives nouvelles, différentes et non visuelles.

En réponse, Midjourney nous a donné des images d'assemblages étranges, semblables à des animaux, avec des caractéristiques éléphantesques, faits de matériaux en bois ou en cuir desséchés, ainsi que des rendus assez réalistes d'un animal ressemblant à un gnou et d'éléphants immédiatement reconnaissables.

Joshua Miele, membre émérite du département Handicap, Accessibilité et Design à l'Institut Othering and Belonging de l'Université de Californie à Berkeley, est chercheur spécialisé dans la conception de technologies adaptatives. Il est également aveugle. Il a décrit un animal que la plupart des gens ne connaissent que de vue :

« Un mammifère quadrupède au pelage fauve tacheté de noir, à la courte queue en balai et au cou très haut surmonté d'une tête étonnamment petite, presque celle d'un chihuahua, arborant un nez retroussé, sans oreilles et deux courtes cornes verticales terminées par des protubérances noires. »

Biggs a décrit le même animal, mais de manière plus concise : « Grand animal à quatre pattes avec un très long cou, des oreilles pointues, des taches et des sabots. »

Privé d'un indice textuel simple comme « une girafe », Midjourney a fait de son mieux pour construire des créatures à partir de ces descriptions. Certains résultats sont étranges et surnaturels, mais par leur étrangeté, quelques-unes des images évoquent les illustrations des naturalistes européens du XVIIe siècle ou les représentations d'animaux exotiques invraisemblables et invisibles des enlumineurs médiévaux, tirées uniquement de témoignages de seconde ou troisième main. Certaines semblent même inclure des textures de parchemin et des écritures à l'encre. Elles rappellent que les défis de la génération d'images à partir du langage sont très anciens, plus anciens même que le texte lui-même.

Il y a aussi des défis dans l'autre sens. Les descriptions textuelles de Biggs et Miele elles-mêmes, mentionnant de longs cous et des taches, font écho à des limitations linguistiques de longue date pour décrire la nouveauté visuelle. De l'Antiquité au XVIIe siècle, l'animal en question était connu de nombreux Occidentaux par un simple amalgame de noms de bêtes plus familières : Camelopard, du grec Kamilopárdali, pour chameau + panthère ou léopard. Comme dans ce nom, les éléments individuels des descriptions de Miele et Biggs sont reconnaissables par les spectateurs voyants dans toutes leurs images, même dans les compositions qui ont peu de ressemblance visuelle avec les girafes.

Il n'y a aucune limite au nombre d'interprétations visuelles concurrentes pouvant être générées, même à partir d'un extrait d'écriture qui ne met en évidence que quelques traits saillants. Il semble donc miraculeux que Midjourney puisse se rapprocher de la précision d'une description. Pourtant, plusieurs des images de girafes de Biggs étaient des sosies. Il a eu de la chance, et un avantage considérable sur les moines médiévaux : la synthèse texte-image par IA est comparable à des caractères mobiles pour la rhétorique visuelle. La description plus simple de Biggs a apparemment suffi à guider Midjourney vers l'intersection statistique et sémantique de son texte et des régions « girafes » de milliards d'images de référence de l'IA, et à sélectionner les jeux de caractères visuels appropriés.

Quelle doit être la précision des descriptions écrites des utilisateurs aveugles pour qu'ils puissent saisir de larges fragments thématiques de rhétorique visuelle et établir des liens significatifs avec la culture visuelle que les voyants pourraient reconnaître ou auxquels ils pourraient réagir ? Et si nous nous aventurons sur un terrain profondément subjectif, comment évaluer les résultats ? Quels critères utiliser ? Que nous apprennent les échecs et les limites ? Que signifient les images ?

DÉCODAGE ET RECODAGE DU PATRIMOINE CULTUREL

Lindsay Yazzolino est une spécialiste et chercheuse en technologies tactiles, aveugle. Elle conçoit des outils d'orientation et de communication tactile. Avec Biggs, elle a décrit plusieurs œuvres d'art visuel célèbres, une proposition inhabituelle et stimulante, et ce, pour des raisons plus qu'évidentes. « L'exposition et les références implicites des personnes voyantes aux arts visuels, ainsi que leurs allusions à leur contenu et à leur signification, excluent généralement les personnes aveugles du discours sur ces sujets », explique Biggs.

Fournir à Midjourney des descriptions d'œuvres non identifiées par leur nom – considérées comme acquises et rarement expliquées en détail par les personnes voyantes – permet non seulement de tester l'IA en la contraignant aux descriptions spécifiques des auteurs, mais aussi de permettre aux utilisateurs aveugles d'illustrer leur propre compréhension non visuelle d'œuvres qu'ils ne connaissent que par les descriptions des personnes voyantes. Les images ainsi créées pourraient également servir de retour visuel intéressant aux créateurs voyants quant à leur capacité à communiquer avec le public non visuel au sujet d'œuvres importantes.

Les images générées par l'IA de Biggs et Yazzolino peuvent, dans un certain sens, « échouer » à ressembler visuellement aux œuvres originales auxquelles elles font référence. Cependant, l'utilisation de sujets familiers uniquement aux publics voyants – et chargés de sens visuellement codés – pourrait nous donner une idée du potentiel de Midjourney pour élargir le discours, relier le langage des utilisateurs aveugles à des artefacts visuels pertinents et susciter des résonances significatives entre les textes des auteurs, leurs thèmes et leurs publics voyants, d'une manière que seule l'imagerie peut peut-être.

Interpréter ces résonances peut être intrinsèquement non scientifique, mais prendre au sérieux l'impact des images et les replacer dans un contexte historique et culturel est un élément important de l'évaluation du potentiel de communication de ces outils.

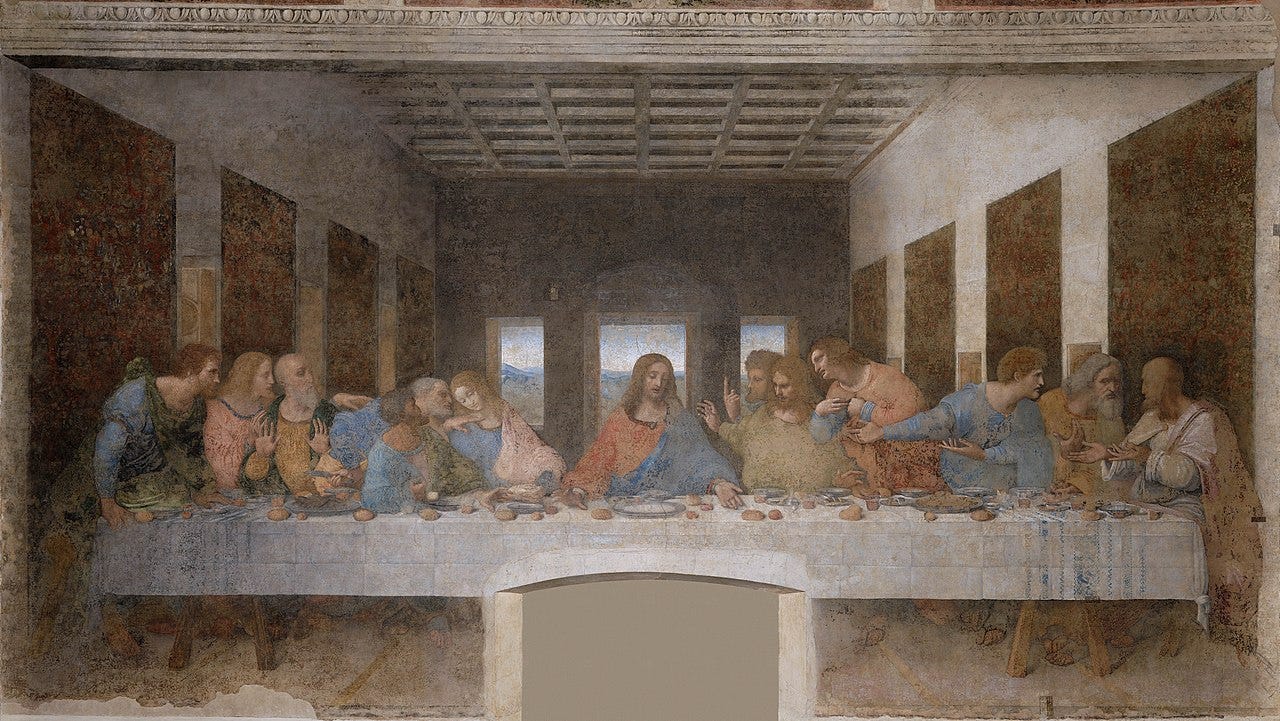

Pour illustrer le point de vue de Biggs sur l’exposition et le discours, il a décrit La Cène de Léonard de Vinci et a inclus un détail qu’il connaît de la Bible qui n’est pas réellement représenté dans l’œuvre de Léonard : « Un tableau de Jésus lavant les pieds d’un de ses disciples, tandis que les autres sont assis autour d’une table en train de dîner. »

Les styles des images qui en résultent vont du primitif au surréaliste, en passant par le kitsch, mais chacune évoque des rassemblements intimes et sombres. Et, spontanément, dans un clin d'œil apparent à Léonard de Vinci, dans l'une de ses images, Midjourney a disposé les sujets et leur table autour d'un point de fuite central – une construction qu'elle a radicalement bouleversée dans les images de Yazzolino représentant la même scène. Elle a décrit le tableau de Léonard de Vinci, qu'elle ne connaît que par d'autres descriptions, comme un « tableau célèbre représentant Jésus avec ses disciples la nuit précédant sa crucifixion ».

À l'instar de la composition de Léonard, plusieurs images issues de la description de Yazzolino invitent le spectateur à se poser face à face avec Jésus et ses disciples, Jésus au centre. Mais certaines vont bien plus loin. Dans une version, avec une croix marquée de cendres sur le front, Jésus nous regarde droit dans les yeux, blessés et ensanglantés.

Là où Léonard de Vinci maîtrisait parfaitement la perspective linéaire à un point, alors innovante, avec son architecture et son environnement s'éloignant au loin, la profondeur de cette nouvelle image est aplatie, comme vue à travers un téléobjectif. Dans une hiérarchie byzantine emblématique, Jésus est représenté bien plus grand que ses disciples, les dominant de toute sa hauteur.

Le point de fuite et l'échelle spatiale de cette composition ont non seulement été complètement inversés, mais Midjourney a apparemment synthétisé un élément spécifique de la description de Yazzolino – « un tableau célèbre » – en une perspective saisissante, résolument du XXIe siècle. Semblant reconnaître que les images de tableaux « célèbres » présentent souvent une foule de visiteurs au premier plan, Midjourney a représenté, au bas de cette composition, les nuques sombres des personnes qui contemplent le tableau avec nous ; nous sommes dans la salle bondée avec eux, regardant au-dessus d'eux. Ils sont à peu près de la même taille que les disciples et à leur portée. Un disciple, le troisième à gauche de Jésus – là où Judas est placé dans la représentation de Léonard – regarde ailleurs, tandis qu’un autre regarde vers le bas, directement vers les spectateurs représentés.

Ces spectateurs, dans l'ombre, sont flous, comme photographiés en longue exposition, en faible luminosité, rétroéclairés par leurs propres lumières, qu'ils tiennent face au tableau – ce qui semble être des téléphones portables qu'ils utilisent pour créer leurs propres images du tableau dans l'image. La lumière jaune qu'ils projettent sur le tableau est rendue comme la lumière du tableau lui-même.

L'image synthétique de Yazzolino succède à celle de Léonard de Vinci en ne se contentant pas de s'adapter à ses spectateurs, mais en les intégrant, avec leur présence physique, leur éclairage, leur acte de contemplation et de mémorisation, et nous avec eux, dans le tableau que nous contemplons ensemble. Cette perspective communautaire est une manière saisissante de transmettre l'intimité et offre une toute nouvelle forme de profondeur.

Yazzolino souligne que, dans son propre travail d'aide aux designers et aux commissaires d'exposition pour communiquer des informations visuelles à un public aveugle, « il semble parfois que même les personnes voyantes aient beaucoup de mal à identifier et à expliquer avec des mots ce qui est important dans une œuvre d'art. » Et cela ne concerne que l'image elle-même. Au-delà, il est impossible d'identifier toutes les connaissances tacites que les spectateurs voyants apportent lors d'une visite pour éclairer ou motiver leurs réactions. Des allusions subtiles, des gestes vaguement familiers, des couleurs ou des mythes oubliés, et un contexte crucial peuvent inciter un public voyant à reconnaître le sens d'une image, ou à en générer lui-même sans en connaître la différence.

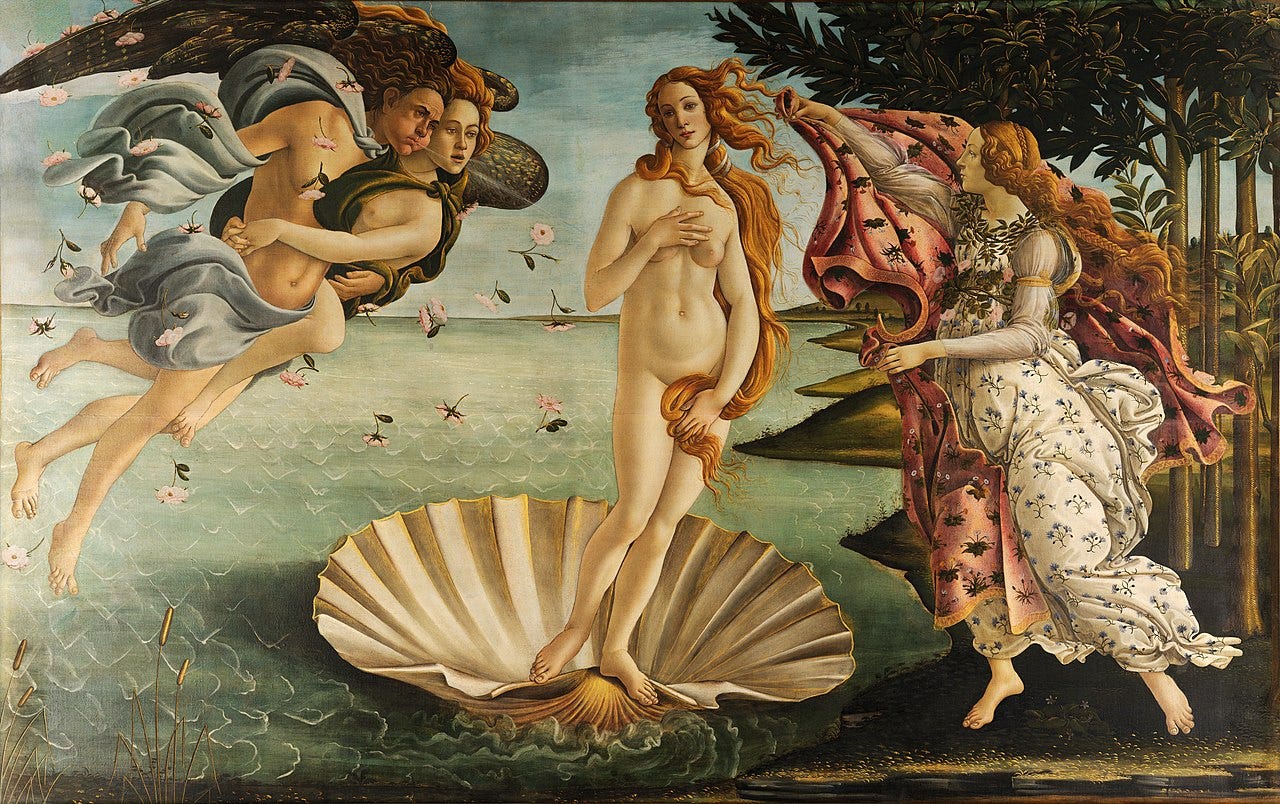

Même si leurs auteurs aveugles ne peuvent pas se porter garants de ce que les personnes voyantes voient dans leurs images générées par l'IA, il y a certainement du sens à découvrir si nous y sommes ouverts, même si nous ne pouvons pas savoir avec certitude d'où ni quand il vient. Par exemple, les rendus de Midjourney de la description par Yazzolino de La Naissance de Vénus de Sandro Botticelli (XVe siècle) – « un célèbre tableau représentant une déesse représentée par la deuxième planète du système solaire » – laissent entrevoir la capacité de l'IA de Midjourney à exploiter un catalogue visuel riche de la culture populaire pour créer des figures, des visages et des styles évoquant des divinités antiques et classiques.

Yazzolino n'a bien sûr pas mentionné le nom de « Vénus », mais deux de ses images présentent une femme en pose de face, les mains levées de chaque côté, à l'image d'Ishtar, la déesse babylonienne de l'amour, de la beauté, de la fertilité et de la guerre, associée à la planète Vénus, qui brandit des instruments symbolisant sa divinité dans la plaque Burney, vieux de 3 800 ans.

Une autre de ses images montre une figure féminine, sans bras, debout, drapée d'un tissu flottant qui lui tombe des hanches, telle la Vénus de Milo, sur un fond marbré représentant une planète. Une autre représente une figure féminine plus réaliste, les bras intacts, tenant une planète, avec le visage de Vénus de Milo.

Biggs a écrit deux descriptions du même Botticelli, donnant naissance à des visions mythiques radicalement différentes. Sa première description : « Une femme ailée survolant l’océan, avec un dieu du vent de chaque côté. Les dieux du vent ont une forme humaine et des ailes. »

L'accent mis par Biggs sur le vent et les ailes a peut-être incité Midjourney à créer une imagerie davantage inspirée de la sculpture grecque antique de la déesse Niké, la Victoire de Samothrace, avec ses ailes et son tissu balayé par le vent, se posant sur la proue d'un navire de guerre, que de Vénus ou de toute autre peinture de la Renaissance.

Dans sa deuxième description, Biggs s'est lui-même illustré en train d'explorer un hypothétique modèle tactile de Botticelli :

« Je déplace mes mains sur le rendu 3D de ce tableau. À droite, je sens un visage, une tête humaine et un corps humanoïde aux ailes s'étendant vers la gauche du tableau. Sous les pieds de cette créature, des vagues d'eau. En déplaçant mes mains vers la droite, je sens un autre corps humain, celui d'une femme, émerger de l'eau au centre du tableau. À droite, une autre créature humanoïde ailée fait face au côté droit du tableau. Les deux créatures, sur les bords du tableau, observent la femme au centre émerger de l'eau. »

Midjourney ne semble pas avoir formé un tout unique et cohérent à partir de la mise en scène spécifique de Biggs, mélangeant plutôt l’observateur avec son objet dans des compositions vives et fantastiques et des symétries ardentes qui évoquent les peintures religieuses mystiques de William Blake plus que celles de Botticelli.

Dans tous les cas, ce sont les textes des participants – et non leurs images – qui constituent l'expression définitive de leur compréhension des sujets, ou du moins de ce qu'ils ont choisi de nous en faire part. Pourtant, les traces visuelles des œuvres originales célèbres que l'on retrouve parfois dans les images de synthèse peuvent être frappantes et déroutantes, surtout compte tenu du caractère aléatoire et des descriptions succinctes de Midjourney.

Par exemple, Yazzolino a décrit La Nuit étoilée de Vincent van Gogh comme un « tableau célèbre représentant une scène céleste d'obscurité ». Outre leur thème, aussi intéressantes, sombres et attrayantes soient-elles, les images qui en résultent, sans ses coups de pinceau vibrants, présentent peu de similitudes visuelles avec l'œuvre de Van Gogh.

Mais inspiré par la description tout aussi concise de Biggs du David de Michel-Ange, « une grande statue en marbre d'un homme musclé, tenant une fronde », Midjourney a généré des images de sculptures inachevées en pierre grossièrement taillée et à la musculature hyper détaillée qui évoquent instantanément la pose déterminée et prête du chef-d'œuvre de la Renaissance.

La description de Biggs de la Joconde de Léonard de Vinci invoquait l’indétermination – « Un petit tableau d’une femme derrière des couches de verre dans une galerie d’art, avec une expression inconnaissable sur son visage » – avec des résultats mitigés.

Son empreinte « derrière la vitre » se reflète dans plusieurs images, comme un reflet qui traverse des portraits simples et librement peints. Dans d'autres, Midjourney crée une atmosphère plus dramatique et cinématographique, avec des compositions plus dynamiques et des reflets et distorsions complexes dans la vitre, sur des visages plus réalistes, mais pas tout à fait vivants. Leurs expressions varient du vide au sourire subtil, en passant par la concentration et l'inquiétude. Les images diffèrent autant les unes des autres que de l'œuvre originale, et sans contexte, aucune ne se reconnaît immédiatement comme faisant référence à la Joconde.

VISUALISER LA SÉMANTIQUE ET SAISIR DES CONNEXIONS PLUS PROFONDES

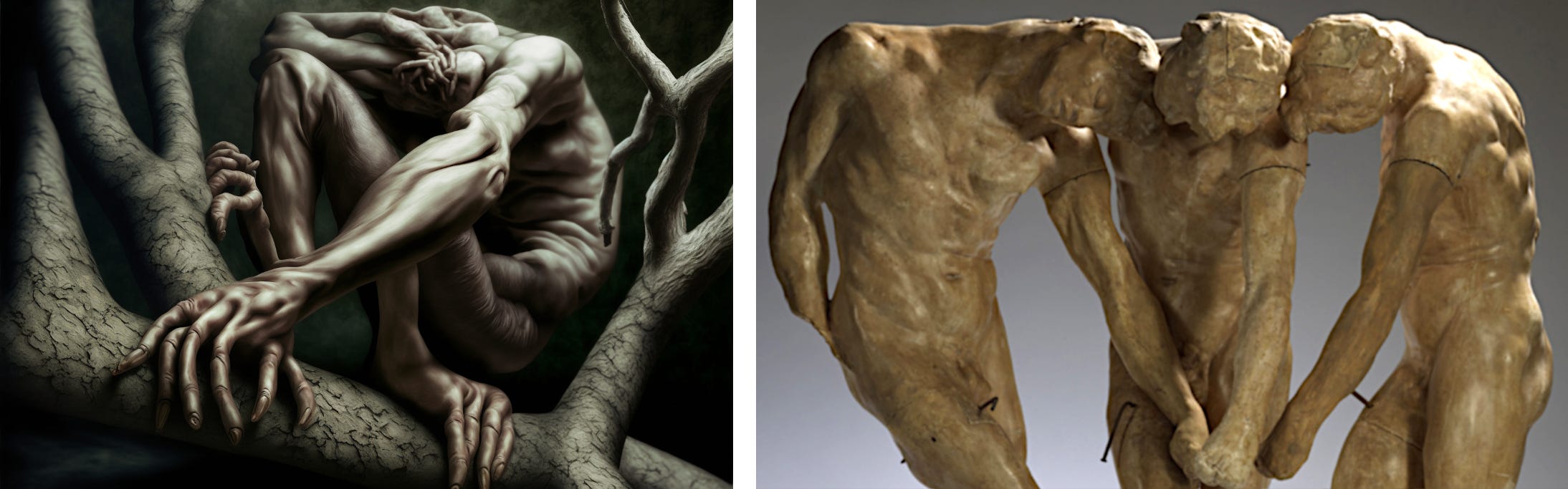

En organisant les résultats du projet, j'avais initialement pensé utiliser plusieurs des images suivantes comme exemples spectaculaires de ratés – ou peut-être ne pas les montrer du tout. Miele avait décrit une sculpture de sa propre création, destinée à exprimer son appréciation du style des œuvres d'Auguste Rodin. C'était un sujet que j'avais suggéré, et il s'est avéré que Miele en connaissait quelques exemples de première main pour les avoir touchés. Miele a écrit :

« Des membres épais et des doigts trapus, des hommes petits et des parties de corps de bébé tordues, entrelacées et partiellement encastrées, s'efforçant et se débattant malgré une frustration et un échec inévitables, face à des forces infernales retenues contre des probabilités à peine meilleures.»

Je ne sais pas quelles sculptures de Rodin Miele a pu toucher. Nombre de ses œuvres les plus connues sont anodines selon les critères modernes – Le Penseur et Le Baiser, par exemple – et le texte de Miele n'en évoque certainement pas. Mais j'ai d'abord pensé à ces résultats comme des échecs, principalement parce que je doutais que Miele ait voulu créer des images viscéralement désagréables. Lorsque nous avons examiné ses résultats par téléphone, je lui ai dit que beaucoup d’entre eux étaient inquiétants et j’ai suggéré que « parties du corps du bébé » semblait être un indice de texte lourd.

Je reconnais cependant dans le texte de Miele le thème récurrent de l'anatomie agonisante, articulée de manière non conventionnelle, que l'on retrouve dans nombre d'œuvres moins accessibles de Rodin. Connaissant certaines œuvres de Rodin directement, par le toucher, Miele ne se limitait pas à retraiter les descriptions visuelles d'autres personnes. Et contrairement aux descriptions antérieures d'œuvres célèbres par Biggs et Yazzolino, le sujet de Miele n'était pas une œuvre spécifique, mais un style, qu'il décrivait de manière trop poétique pour être disséqué avec précision. Il n'est donc pas surprenant que les images générées par ses textes ne ressemblent pas à des sculptures de Rodin à première vue.

Pourtant, plus je les observe, plus je perçois le lien entre les images de Miele et les sculptures de Rodin. Leurs nœuds embryonnaires, serrés, fusionnés et déformés, font de l'ombre aux silhouettes déformées de Rodin, ses mains menaçantes et hypertendues, aux doigts de plâtre douloureusement crispés.

Les images les plus sanglantes de Miele partagent quelque chose en commun avec l’inventaire de parties du corps en plâtre sectionnées de Rodin, que le sculpteur appelait abattis – des expressions anatomiques discrètes et exagérées adaptées d’œuvres de la Renaissance et de la Grèce antique, prêtes à être recyclées, réutilisées et échangées d’un torse à l’autre pour itérer rapidement de nouvelles œuvres à une échelle moderne et industrielle.

L’exploration par Rodin de l’expressivité des mains irrégulières, étrangement posées et vaguement modelées semble en phase avec l’accent tant décrié de Midjourney sur le geste plutôt que sur la précision, l’accent que le texte de Miele exigeait clairement.

Même si Miele n’a pas nommé « Rodin » ni mentionné « sculpture », il y a une connexion esthétique distillée et rendue ici dans cette anatomie contorsionnée, ces gestes de préhension et cette imagerie embryonnaire.

Aussi désagréables que puissent paraître certaines de ces images de synthèse, elles constituent un véritable croisement entre le sens du toucher de Miele, sa compréhension des œuvres de Rodin, son interprétation, son texte et le choix statistique et algorithmique de motifs visuels pertinents de Midjourney. À l'instar des artistes humains avant elle, l'IA a choisi elle-même des éléments visuels parmi un inventaire préexistant de sa vaste base de données de références culturelles, les a recyclés, réutilisés et adaptés pour refléter les mots de Miele dans un nouveau texte.

Je pense que ces images constituent les résultats les plus fascinants et les plus prometteurs du projet. Elles illustrent la capacité des intelligences artificielles à découvrir, exploiter et exprimer des liens profonds, inattendus, sémantiques, émotionnels et narratifs entre perception, langage et imagerie.

VISIONS D'UN AVENIR DE L'IA

Notre collaboration a produit plus de quatre mille images, et chacune soulève plus de questions qu'elle n'apporte de réponses, tout comme le projet lui-même. La suite reste incertaine.

Cette technologie progresse à un rythme effréné. Il semble que les améliorations soient plus rapides que nous ne puissions identifier les meilleures pratiques disponibles actuellement. Il semble exister une fonctionnalité essentielle permettant de communiquer visuellement certains types de sens – quel que soit son auteur, y compris les personnes aveugles – avec un potentiel très étrange. Mais elle manque de précision et de mécanismes de retour d'information.

Midjourney a récemment commencé à tester un outil de description d'image en texte qui fournit aux utilisateurs des commentaires écrits sur le contenu, l'ambiance et le style des images, afin de les aider à perfectionner leurs compétences en rédaction. Avec quelques améliorations, les utilisateurs aveugles pourraient l'utiliser pour recevoir rapidement un retour automatisé sur leurs propres créations d'images, avec des descriptions détaillées de leurs sujets et compositions. Cette nouvelle fonctionnalité pourrait aider les utilisateurs aveugles à produire des ressources visuelles avec une certaine assurance que les résultats reflètent bien leur intention. C'est une voie évidente pour notre exploration et nos expérimentations continues, et si les développeurs de Midjourney se penchent sur certains cas d'utilisation qu'ils n'avaient peut-être pas anticipés, cela pourrait ouvrir de nombreuses possibilités aux utilisateurs aveugles.

Lorsque les systèmes de modélisation 3D par IA seront bientôt disponibles, les utilisateurs aveugles pourront utiliser des dispositifs de retour haptique VR à granularité fine ou d'autres écrans tactiles pour inspecter et interagir physiquement avec leurs créations numériques par le toucher, ou pour les imprimer en 3D et tenir des objets tangibles du monde réel, quels qu'ils soient ou qu'ils représentent.

Mais d'autres innovations sont en préparation, et bientôt, et une grande partie semble être axée sur le visuel. La conversion de texte en vidéo par IA progresse rapidement, et les chercheurs utilisent la technologie sous-jacente qui alimente Midjourney pour convertir l'imagerie cérébrale IRMf en images cohérentes de l'imagerie mentale des sujets. Nous pourrons peut-être bientôt enregistrer les images de nos rêves.

Miele s'inquiète du fait que les personnes aveugles soient exclues des avancées de l'IA axée sur la vision : « Lorsque la génération d'images assistée par l'IA sera connectée à la biométrie et à l'activité cérébrale directe pour les entrées émotionnelles et cognitives (au lieu du texte), qui aura encore besoin du langage parlé ? Eh bien… les personnes aveugles en auront besoin, ainsi que toute personne présentant une neurodivergence du traitement visuel. Le nouveau monde de la génération d'images par l'IA pourrait donc être formidable pour les personnes voyantes, mais je suis un peu inquiet des nouvelles barrières de communication qu'elle pourrait engendrer pour les personnes aveugles. »

Je vois l'inquiétude de Miele comme un contrepoint à une critique de l'imagerie générée par l'IA, qui fait écho à une critique désuète de certains arts abstraits, ainsi que de toute forme d'art assisté par ordinateur : nier la valeur d'une œuvre en remettant en question les compétences ou les outils de l'artiste, notamment en affirmant : « N'importe qui pourrait faire ça.» Dans notre contexte, cette observation salue bien sûr les outils de synthèse d'images par l'IA, car c'est là tout l'intérêt. Grâce à ces outils, chacun peut créer des images. C'est l'une des raisons pour lesquelles cette technologie est si radicale et si importante. Et pour répondre aux préoccupations de Miele, c'est pourquoi nous devons continuer à explorer les moyens de concrétiser ce projet.

Cosmo Wenman est CEO de Concept Realizations. Vous pouvez le contacter sur twitter.com/CosmoWenman et cosmo.wenman@gmail.com

Si vous avez apprécié cet article, n'hésitez pas à le partager et à vous abonner. J'écrirai davantage sur ce projet, notamment sur les images liées à la culture pop et à l'écriture créative que nous avons créées. Je publierai également ici des articles occasionnels sur les technologies et le design d'accès universel, la numérisation 3D et la réplication d'œuvres d'art, et bientôt des mises à jour importantes concernant mon procès pour atteinte à l'accès à l'information intenté à Paris contre le musée Rodin, dans le cadre duquel je cherche à établir l'accès public à tous les scans 3D d'œuvres du domaine public des musées nationaux français.

À PROPOS DU PROJET ET DE SES PARTICIPANTS

Les 4 110 images résultant du projet, ainsi que leurs textes d'invite et paramètres Midjourney, sont accessibles via conceptrealizations.com/ai-experiment-images-prompts.

Les trois participants ayant contribué aux textes de synthèse et collaboré à la conception du projet :

Brandon Biggs, PDG de XR Navigation, directeur financier de Sonja Biggs Educational Services Inc. et ingénieur au Smith-Kettlewell Eye Research Institute. Il est titulaire d'un master en design inclusif de l'Université de l'École d'art et de design de l'Ontario et est doctorant en informatique centrée sur l'humain au Georgia Institute of Technology. Vous pouvez le contacter sur brandonkeithbiggs.com.

Joshua Miele, chercheur scientifique spécialisé en conception de technologies adaptatives, lauréat MacArthur 2021, membre émérite en handicap, accessibilité et design à l'Institut Othering and Belonging de l'Université de Californie à Berkeley, et chercheur principal en accessibilité au Lab126 d'Amazon. Avant de rejoindre Amazon, Miele a mené des recherches sur les graphismes tactiles et les affichages auditifs au Smith-Kettlewell Eye Research Institute. Vous pouvez le contacter sur twitter.com/BerkeleyBlink.

Lindsay Yazzolino, designer non visuelle, possède une formation en neurosciences cognitives et en accessibilité des transports en commun. Chercheuse en neurosciences cognitives, elle étudie l'influence de la cécité sur les capacités cognitives telles que la lecture en braille, le langage et la perception tactile et sonore. Designer d'expérience utilisateur chez CVS Health, elle est également spécialiste des technologies tactiles et collabore avec des scientifiques, des musées et des développeurs de produits pour créer des œuvres d'art et des expériences multisensorielles et captivantes. Vous pouvez la contacter à l'adresse lindsay3.14@gmail.com.

Le projet a été conçu et organisé par Cosmo Wenman, CEO de Concept Realizations, une entreprise de conception et de fabrication numérique spécialisée dans la conception d'expositions tactiles et accessibles à tous, la reproduction d'œuvres d'art et les applications de fonderie de bronze. M. Wenman est également un militant pour le libre accès au patrimoine culturel. Vous pouvez le contacter sur twitter.com/CosmoWenman.